Che cos’è l’Intelligenza Artificiale Spiegabile?

L’Explainable AI (XAI) si riferisce a un insieme di tecniche e processi che consentono di comprendere il razionale alla base dei risultati prodotti da un algoritmo di Machine Learning. Grazie alla XAI, puoi migliorare e correggere i tuoi modelli, soddisfare requisiti normativi e aumentare la fiducia nelle decisioni e previsioni dei tuoi modelli di AI.

Benefici

L’interesse per l’XAI sta crescendo rapidamente, poiché le organizzazioni riconoscono la necessità di ottenere informazioni sui processi decisionali dei modelli di AI “opachi” o “black box”. Questi approfondimenti offrono cinque principali benefici:

- Miglioramento delle decisioni: Comprendere come influenzare i risultati previsti.

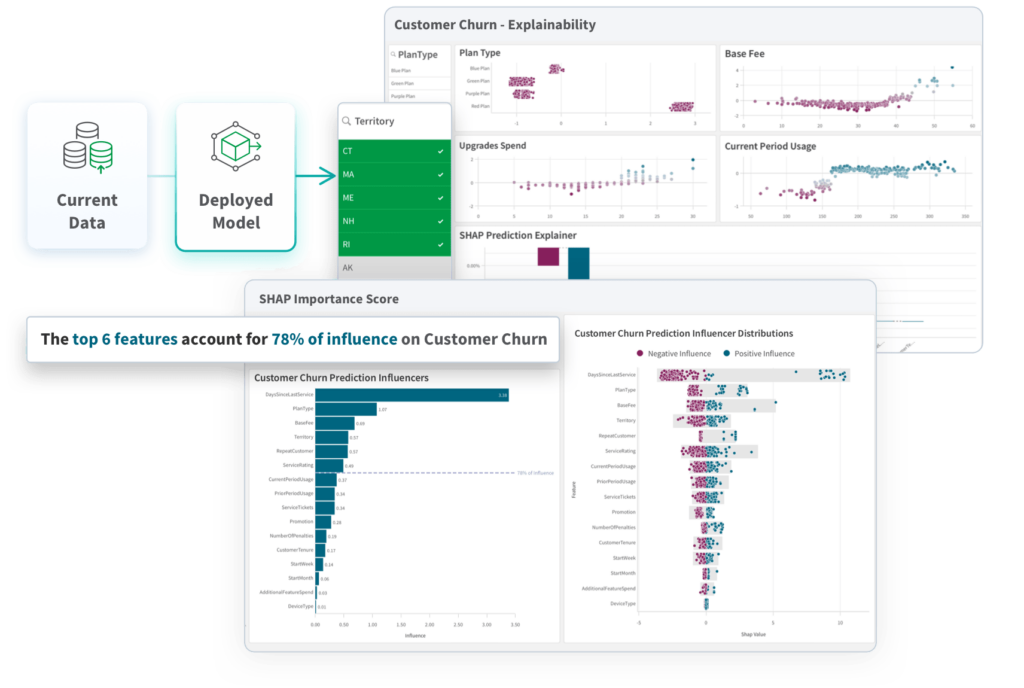

Ad esempio, il tuo modello predittivo potrebbe generare previsioni sui clienti a rischio di abbandono (churn) basandosi sui tuoi dati. Con l’XAI, ottieni spiegazioni interpretabili e trasparenti delle decisioni prese dai tuoi modelli di analisi.

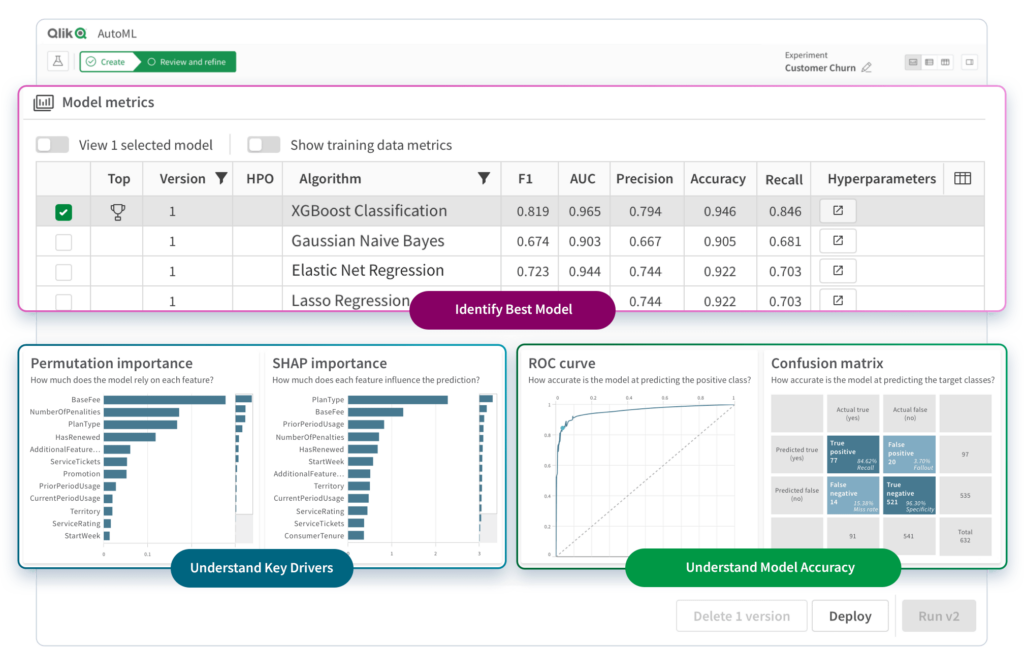

- Ottimizzazione più rapida dell’AI: Monitorando e valutando i modelli, è possibile identificare quale modello performa meglio, quali sono i driver chiave e quanto è accurato.

- Maggiore fiducia e riduzione del bias: Le spiegazioni XAI mostrano i pattern trovati dal modello nei dati, aiutando il team di MLOps a tracciare errori e a valutare l’integrità dei dati.

- Incremento dell’adozione: La maggiore comprensione e fiducia nei sistemi di machine learning e AutoML favorisce l’integrazione delle soluzioni di analisi predittiva, prescrittiva e aumentata.

- Conformità normativa: Le spiegazioni possono essere utilizzate per verificare che le decisioni basate sull’AI siano conformi alle normative in continua evoluzione.

Approcci all’Intelligenza Artificiale Spiegabile (XAI)

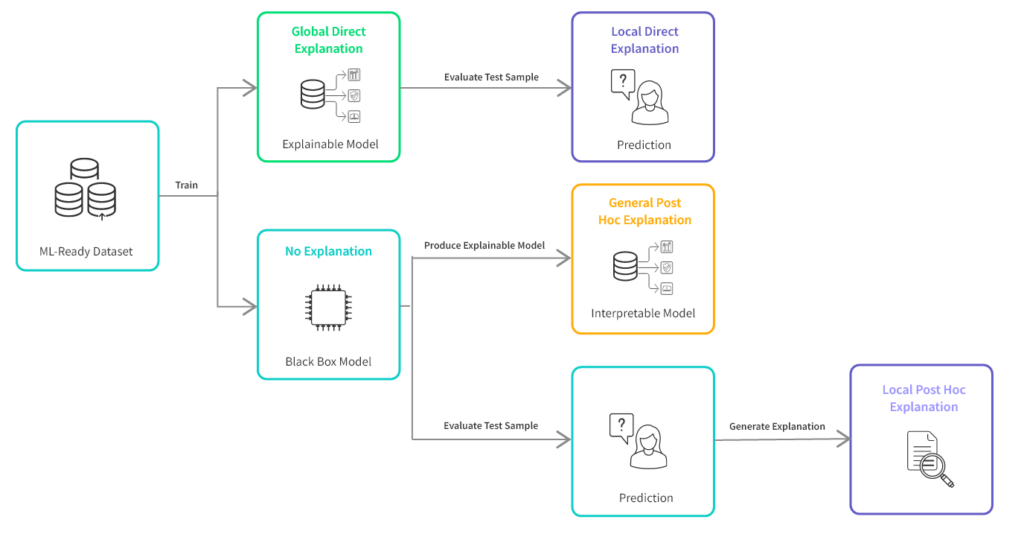

Non esiste un unico approccio ottimale per spiegare i risultati di un algoritmo di machine learning o di intelligenza artificiale. Esistono tre approcci principali da considerare: globale vs locale, diretto vs post hoc e dati vs modello. La scelta dipenderà dai requisiti della tua pipeline di machine learning e dal destinatario delle spiegazioni (ad esempio, un data scientist, un regolatore o un decisore aziendale).

Globale vs locale

Questo approccio riguarda l’ambito della spiegazione:

- Modelli globali: Forniscono una comprensione ad alto livello di come il tuo modello di AI genera previsioni. Solitamente riassumono le relazioni tra le caratteristiche in ingresso e le previsioni in modo astratto. Ad esempio, una spiegazione globale potrebbe evidenziare le caratteristiche più importanti nel tuo modello e il modo in cui influenzano la previsione.

- Modelli locali: Offrono spiegazioni specifiche a livello di singola istanza per previsioni individuali. Mostrano il contributo esatto di ciascuna caratteristica per una determinata previsione. Ad esempio, in un’analisi predittiva, una spiegazione locale per una previsione sul rischio di credito di un cliente potrebbe indicare i fattori specifici, come il reddito e la storia creditizia, che hanno portato alla previsione.

Diretto vs post hoc

Questo approccio si riferisce al modo in cui il tuo modello è progettato per fornire spiegazioni:

- Modelli diretti (“white box”): Sono progettati per produrre previsioni interpretabili fin dall’inizio. La loro architettura, funzioni di perdita e regolarizzazione sono costruite pensando all’interpretabile. Ad esempio, alberi decisionali o regressioni logistiche sono tipi di modelli diretti, poiché la loro struttura offre una spiegazione chiara e interpretabile delle previsioni. Modelli più complessi, come Gradient Boosted Decision Tree (ad esempio LightGBM, H20, XGBoost, Catboost e AdaBoost), si trovano a metà strada tra “white box” e “black box” nello spettro della spiegabilità.

- Modelli post hoc (“black box”): Non sono progettati per essere interpretabili fin dall’inizio, ma è possibile generare spiegazioni in un secondo momento utilizzando strumenti o processi separati. Ad esempio, una rete neurale è un tipo di modello post hoc, poiché produce previsioni difficili da interpretare. Tuttavia, tecniche come SHAP (SHapley Additive exPlanations) possono essere utilizzate per generare spiegazioni post hoc delle sue previsioni. A differenza dei modelli diretti, le spiegazioni post hoc possono fornire ulteriori approfondimenti sul funzionamento di modelli più complessi.

Dati vs modello

Questo approccio si riferisce al tipo di spiegazione fornita:

- Modelli basati sui dati: Forniscono spiegazioni basate sui dati di input pronti per il machine learning e sulle relazioni tra le caratteristiche. Questo tipo di spiegazione si concentra sul rapporto tra le caratteristiche di input e le previsioni, mostrando come i cambiamenti nei dati di input influenzano i risultati. Ad esempio, un albero decisionale è un modello XAI basato sui dati, poiché fornisce spiegazioni basate sulle divisioni dell’albero e sull’influenza delle caratteristiche di input sulle previsioni. In genere, i modelli basati sui dati offrono spiegazioni più trasparenti rispetto ai modelli basati sul modello.

- Modelli basati sul modello: Forniscono spiegazioni analizzando il funzionamento interno del tuo modello. Si concentrano su come il modello elabora i dati di input e utilizza le rappresentazioni interne per generare previsioni. Ad esempio, le reti neurali rientrano nei modelli basati sul modello, poiché forniscono spiegazioni basate sui pattern di attivazione nella rete e sul modo in cui tali attivazioni influenzano la previsione. I modelli basati sul modello offrono approfondimenti più dettagliati sul funzionamento interno rispetto ai modelli basati sui dati.

Sfide dell’XAI

Fornire spiegazioni che siano sia accurate che facili da comprendere presenta diverse sfide:

- I modelli XAI possono essere complessi e difficili da comprendere, anche per esperti di machine learning.

- È complicato verificare la correttezza e la completezza delle spiegazioni.

- L’elaborazione può richiedere risorse computazionali significative, rendendo difficile scalare per dataset di grandi dimensioni e applicazioni reali.

- Spesso si deve scegliere tra trasparenza e accuratezza, sacrificando l’una per aumentare l’altra.

- L’integrazione nei sistemi AI esistenti può richiedere modifiche sostanziali ai flussi di lavoro.

Best Practices per Implementare l’XAI

Ecco alcune pratiche chiave per implementare con successo l’Explainable AI:

Crea un comitato di governance AI multidisciplinare

Costituisci un comitato che includa non solo esperti tecnici, ma anche leader aziendali, legali e responsabili del rischio. Questo comitato guiderà i team di sviluppo AI definendo il framework organizzativo per l’XAI e identificando gli strumenti più adeguati alle tue esigenze. Inoltre, stabilirà standard in base ai diversi casi d’uso e ai livelli di rischio associati.

Investi in talenti e strumenti appropriati

Forma il personale e acquisisci gli strumenti giusti per implementare l’XAI nella tua organizzazione, rimanendo aggiornato in questo campo in rapida evoluzione. La scelta tra strumenti personalizzati, pronti all’uso o open-source dipenderà dalle necessità a breve e lungo termine.

Definisci chiaramente i tuoi casi d’uso o problemi

Identifica il contesto decisionale in cui verrà utilizzata l’XAI. Questo aiuta a garantire la comprensione dei rischi specifici e dei requisiti legali per ciascun modello.

Considera il pubblico destinatario del tuo sistema XAI

Valuta il livello di spiegazione necessario affinché il tuo pubblico (data scientist, regolatori, manager aziendali, ecc.) possa comprenderlo.

Scegli tecniche XAI appropriate

Seleziona le tecniche più adatte al problema e al caso d’uso definiti, come l’importanza delle caratteristiche, i metodi indipendenti dal modello o i metodi specifici del modello.

Valuta i tuoi modelli XAI

Utilizza metriche come accuratezza, trasparenza e coerenza per garantire che i modelli forniscano spiegazioni affidabili e precise. Potrebbe essere necessario bilanciare il compromesso tra spiegabilità e accuratezza.

Testa i modelli XAI per il bias

Verifica che i tuoi modelli siano equi e non discriminatori.

Monitora e aggiorna continuamente i tuoi modelli XAI

Assicurati che rimangano accurati, trasparenti ed equi nel tempo.

Rispetta i quattro principi dell’Intelligenza Artificiale Spiegabile definiti dal NIST:

- Spiegazione: Ogni output deve essere accompagnato da evidenze o motivazioni che lo supportino.

- Comprensibilità: Le spiegazioni devono essere adattate per essere comprese da ciascun utente.

- Accuratezza: Il processo di generazione dell’output deve essere riflesso con precisione nella spiegazione.

- Limitazioni di conoscenza: Il sistema deve operare solo entro i parametri per cui è stato progettato o quando raggiunge un livello di confidenza sufficiente nel suo output.

Tecniche Principali

Le tecniche XAI specifiche da utilizzare dipendono dal problema che devi affrontare, dal tipo di modello di AI che utilizzi e dal pubblico destinatario delle spiegazioni. Di seguito sono elencate le principali tecniche XAI utilizzate per produrre spiegazioni accurate e facili da comprendere:

- Importanza delle caratteristiche (Feature Importance):

Questa tecnica evidenzia le caratteristiche in ingresso più importanti che contribuiscono a una determinata decisione dell’AI. - Metodi indipendenti dal modello (Model-agnostic methods):

Queste tecniche forniscono spiegazioni che non sono specifiche per un particolare modello di AI e possono essere applicate a qualsiasi modello “black box”. Esempi includono le saliency maps e LIME (Local Interpretable Model-agnostic Explanations). - Metodi specifici del modello (Model-specific methods):

Queste tecniche forniscono spiegazioni progettate per un particolare modello di AI, come gli alberi decisionali e i modelli basati su regole. - Spiegazioni controfattuali (Counterfactual explanations):

Questa tecnica offre spiegazioni per le decisioni prese dall’AI mostrando quali cambiamenti nei dati di input avrebbero portato a una decisione diversa. - Visualizzazioni (Visualization):

Strumenti di visualizzazione come grafici, heatmap e interfacce interattive possono essere utilizzati per fornire spiegazioni chiare e intuitive sulle decisioni dell’AI.

Come Qlik AutoML e SELDA Informatica Possono Aiutarti

I principi dell’Explainable AI si allineano perfettamente con Qlik AutoML, uno strumento progettato per democratizzare il machine learning e fornire insight attuabili nelle previsioni. Grazie alla sua attenzione alla trasparenza e all’importanza delle caratteristiche, Qlik AutoML aiuta le organizzazioni a guadagnare fiducia nei loro modelli predittivi e a ottimizzare i processi aziendali.

SELDA Informatica, con decenni di esperienza nell’analisi e nella business intelligence, supporta le aziende nell’implementare e sfruttare l’Explainable AI. Offriamo soluzioni personalizzate basate sulla tecnologia Qlik, aiutandoti a integrare l’XAI nei tuoi processi decisionali, garantendo conformità, fiducia ed efficienza.